メカトロニクス制御に関連する気になるカタログにチェックを入れると、まとめてダウンロードいただけます。

AIモ�デルの学習・推論とは?課題と対策・製品を解説

目的・課題で絞り込む

カテゴリで絞り込む

EMC・ノイズ対策技術 |

スマート工場内の搬送系および協働ロボット利活用 |

スマート工場・DX |

パワーエレクトロニクス技術 |

メカトロニクス・制御技術 |

モーション・エンジニアリング |

モータ技術 |

工場内のシステム見える化 |

工場内のデジタルトランスフォーメーション(DX) |

電源システム |

熱設計・対策技術 |

部品加工技術 |

その他メカトロニクス制御 |

AI・ディープラーニングにおけるAIモデルの学習・推論とは?

各社の製品

絞り込み条件:

▼チェックした製品のカタログをダウンロード

一度にダウンロードできるカタログは20件までです。

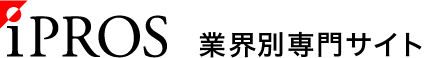

イスラエルにあるVariscite(ヴァリサイト)社は、NXP社製i.MX搭載

システムオンモジュール(SoM)製品のバリエーションが豊富で、かつNXPの

プラチナパートナーであるため、i.MX搭載の新製品を早くリリースしています。

また、100台以上の御注文で、各種オプション(メモリサイズ、無線通信

ICの有無等)も設定が可能。大変使いやすい製品になっています。

NPX社製i.MX8M PLUS搭載のDART-MX8M-PLUSならびに

VAR-SOM-MX8M PLUSの特徴は次の通りです。

【特長】

■最大周波数1.8GHzの Cortex-A53プロセッサ4個

■800MHz Cortex-M7リアルタイムコプロセッサ

■統合ニューラルプロセッシングユニット(NPU)

■画像信号プロセッサ(ISP)、カメラI/F

■人工知能/機械学習(AI / ML)機能を有し、

AI機能などのアプリケーションに好適

※英語版カタログをダウンロードいただけます。

※詳しくはPDF資料をご覧いただくか、お気軽にお問い合わせ下さい。

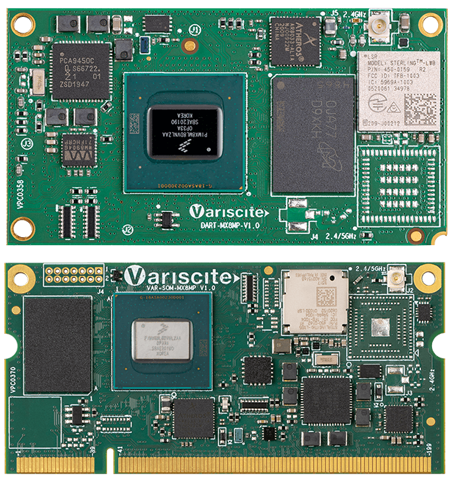

『DSP8066-2』は、テキサス・インスツルメンツ社製C6672搭載で、

VME bus & VXS 対応型の高速デジタル信号処理ボードです。

EclipseをベースとしたT.I.社製の無償の統合開発環境

Code Composer Studioでのソフトウェア開発。

Serial Rapid I/OによるVXS、XMCでの最大8Gbpsの高速データ転送や、

実績のあるVME bus、MTT-Link busによる筐体内データ転送が可能です。

【仕様(抜粋)】

■テキサス・インスツルメンツ(T.I.)社製マルチコアDSPシリーズ

TMS320C6672搭載

■Serial Rapid I/OによるVXS、XMCでの最大8Gbpsの高速データ転送

■実績のあるVME bus、MTT-Link busによる筐体内データ転送

■EclipseをベースとしたT.I.社製の無償の統合開発環境

Code Composer Studioでのソフトウェア開発

※詳しくはPDF資料をご覧いただくか、お気軽にお問い合わせ下さい。

NXP i.MX 8M Plus SoCには最大4つのパワフルな64ビットArmv8 Cortex-A53コアが搭載されており、典型的な産業および医療アプリケーションに十分な電力供給を確保すると同時に最新のグラフィカルユーザーインターフェイスのLinuxを実行する上で、コスト効率に優れた選択肢です。

内蔵されたニューラルネットワークプロセッシングユニット(NPU)は、ディープラーニング推論を実行するためにゼロから設計され、同じ電力範囲のCPUとGPUベースのソリューションの数倍のパフォーマンスを実行

することは出来ます。Toradexは、TensorFlowなど、よく利用される機械学習フレームワークとのインテグレーションを提供します。

お探しの製品は見つかりませんでした。

1 / 1

AI・ディープラーニングにおけるAIモデルの学習・推論

AI・ディープラーニングにおけるAIモデルの学習・推論とは?

メカトロニクス制御において、AI・ディープラーニングのAIモデルの学習・推論は、センサーデータや過去の制御履歴などから、複雑なパターンや関係性を自動的に学習し、未知の状況下での最適な制御判断や予測を行う技術です。これにより、従来のルールベースでは難しかった高度な自律制御や、予知保全、品質向上などを実現します。

課題

大量の学習データ準備の負担

高精度なAIモデルの学習には、多様で質の高い大量のデータが必要ですが、その収集・整備には時間とコストがかかります。

計算リソースの制約

ディープラーニングモデルの学習には膨大な計算能力が必要であり、高性能なハードウェアやクラウド環境が不可欠ですが、導入・運用コストが課題となります。

リアルタイム推論の遅延

制御対象の状況変化に即座に対応するためには、高速な推論が求められますが、複雑なモデルやリソース不足により遅延が発生する可能性があります。

モデルの解釈性と信頼性

AIモデルがなぜそのような判断を下したのか、その根拠を理解することが難しく、特に安全性が求められる制御分野での信頼性確保が課題となります。

対策

データ拡張・合成技術の活用

既存のデータを加工したり、シミュレーションで生成したりすることで、学習データの量を効率的に増やし、多様性を確保します。

エッジコンピューティングの導入

センサーに近い場所で推論処理を行うことで、クラウドへのデータ転送量を削減し、リアルタイム性を向上させます。

軽量化・最適化されたモデルの採用

計算リソースの制約に対応するため、推論速度と精度を両立させた、よりコンパクトなAIモデルアーキテクチャを選択・開発します。

説明可能なAI(XAI)技術の導入

モデルの判断根拠を可視化・分析する技術を用いることで、AIの挙動を理解し、信頼性を高め、デバッグや改善を容易にします。

対策に役立つ製品例

高性能組み込み型AIチップ

限られたリソースでも高速な学習・推論処理を可能にし、エッジデバイスでのAI活用を促進します。

クラウドベースのAI開発システム

大量のデータ処理や複雑なモデル学習に必要な計算リソースを柔軟に提供し、開発効率を高めます。

AIモデル最適化ツール

学習済みモデルを軽量化・高速化し、リアルタイム性が求められる制御システムへの適用を容易にします。

AIモデルの可視化・デバッグ支援ソフトウェア

AIモデルの内部動作を理解しやすくし、問題点の特定や改善を支援することで、信頼性の向上に貢献します。